A Universidade Federal Fluminense (UFF) sediou a II Semana Internacional de Acesso Aberto, que integrou a agenda acadêmica da universidade entre 20 e 24 de outubro de 2025. O evento, organizado pelas Bibliotecas UFF, celebrou o primeiro ano da participação da UFF na Semana Internacional de Acesso Aberto, a assinatura da Declaração de Barcelona e a formação do NUCAUF (Núcleo de Ciência Aberta e Dados de Pesquisa da UFF). O tema central das discussões foi a importância da Ciência Aberta para enfrentar os desafios globais, com destaque para os Dados de Pesquisa como Vetores de Transformação.

O Núcleo NUCAUF foi estabelecido como um grupo de trabalho multidisciplinar, composto por representantes da Superintendência de Documentação, docentes, e membros das Pró-Reitorias de Extensão, Pesquisa, Pós-Graduação e Inovação, Relações Internacionais e da Editora da UFF (EDUF), visando atender às demandas científicas globais.

Programação do Dia 22/10

- Horário: 15:00

- Mediadora: Me. Maria Helena Xavier (Coordenação de Bibliotecas – CBI/SDC/UFF)

ABERTURA: 1 ano das ações do Núcleo de Ciência Aberta da UFF

- Palestrante: Debora do Nascimento (Superintendência de Documentação – SDC/UFF)

- RODA DE CONVERSA | VISIBILIDADE E INOVAÇÃO NA CIÊNCIA ABERTA: DADOS DE PESQUISA COMO VETORES DE TRANSFORMAÇÃO

Gestão de Dados de Pesquisa na Universidade: Visibilidade, transparência e aceleração da Ciência no Estado do Rio de Janeiro

- Palestrante: Profª Drª Luana Sales (Instituto Brasileiro de Informação em Ciência e Tecnologia – IBICT)

Iniciativas de Ciência Aberta com Repositórios de Dados de Pesquisa de Universidades Brasileiras

- Palestrante: Profª Drª Carolina Howard Felicíssimo (Rede Nacional de Ensino e Pesquisa – RNP)

Dados de pesquisa para experimentos de Inteligência Artificial: a experiência do Instituto de Computação com o Dataverse

- Palestrante: Profº Drº Daniel de Oliveira

A Gestão de Dados de Pesquisa como motor da Ciência Aberta

A primeira palestra, conduzida pela Prof. Luana Sales (analista em Ciência e Tecnologia do IBCT/MCTI), abordou a Gestão de Dados de Pesquisa (GDP), contextualizando o movimento da Ciência Aberta.

Da Ciência Fechada ao Acesso Aberto

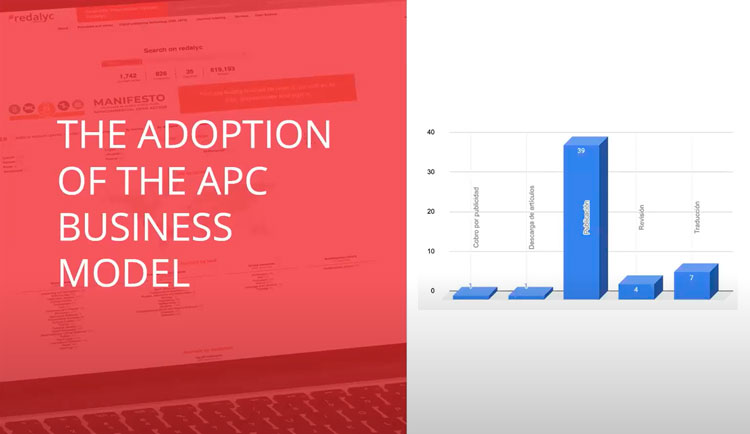

Inicialmente, a ciência nasce de forma aberta, com pesquisadores buscando o compartilhamento do conhecimento para o bem da humanidade. No entanto, o surgimento de periódicos científicos levou a um fechamento do conhecimento, impulsionado por grandes corporações e editoras que geravam receita financeira através da privação de acesso. Esse cenário resultou na crise dos periódicos e na demanda pelo acesso aberto, onde o conhecimento produzido pelos próprios pesquisadores se tornava inacessível para eles.

Definindo Ciência Aberta e GDP

A Ciência Aberta, entretanto, é muito mais do que publicar em acesso aberto. Ela engloba a garantia de transparência nos métodos, reprodutibilidade e acesso à informação para o cidadão comum. O movimento surgiu da necessidade de abrir artigos, mas rapidamente evoluiu para incluir a transparência nas metodologias e o acesso aos dados. A GDP é apenas uma parte da Ciência Aberta, mas fundamental para a visibilidade, transparência e aceleração da ciência.

A pesquisa científica passou da escassez ao excesso de dados (o Big Data Científico), o que transformou o problema de levantar dados para o problema de selecionar e gerenciar dados. Os dados de pesquisa, que funcionam como evidência, são insumos para a produção científica, a base para a reprodutibilidade e para a inovação.

Desafios e Boas Práticas na GDP

Sem uma gestão adequada, os dados de pesquisa se perdem, tornam-se invisíveis e, consequentemente, inúteis. A GDP deve ser planejada desde o início da pesquisa, antes da coleta, e o Plano de Gestão de Dados (PGD) é uma ferramenta essencial para ajudar o pesquisador a pensar sobre a metodologia, a descrição, o compartilhamento e a preservação dos seus dados. A GDP deve preceder a abertura da ciência, pois é nesse momento que se define se os dados podem ou não ser abertos (como no caso de dados sensíveis, regidos pela LGPD).

Um dos elementos cruciais para a GDP é a atribuição de metadados e documentação (como cadernos de laboratório ou arquivos leia-me), que são necessários para que os dados não sejam incompreensíveis.

Cenário Fluminense e os Princípios FAIR

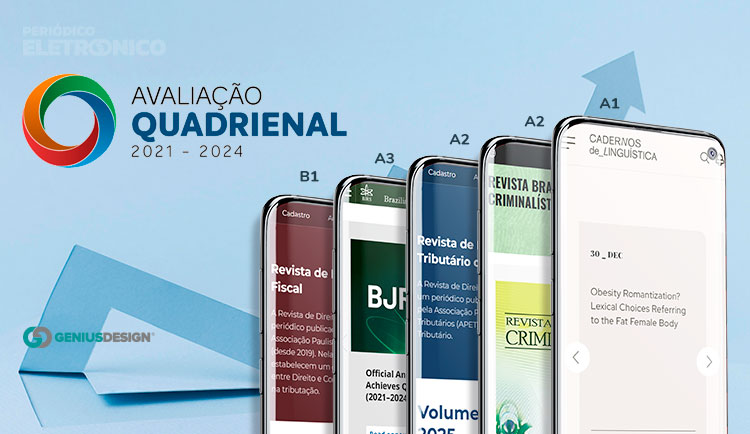

O estado do Rio de Janeiro enfrenta desafios na área, com uma forte produção científica, mas baixa visibilidade dos dados subjacentes, e as universidades ainda não possuem repositórios de dados ou políticas institucionais específicas para dados. O projeto de pesquisa financiado pela FAPERJ busca propor diretrizes baseadas nos Princípios FAIR (Findable, Accessible, Interoperable, Reusable), que visam acelerar a pesquisa científica e aumentar a transparência e visibilidade.

Em relação ao papel do profissional da informação, destacou-se que seu papel é orientar o pesquisador na elaboração do PGD, auxiliando na identificação de repositórios e metadados adequados, mas o PGD em si deve ser feito pelo pesquisador.

Infraestrutura, Repositórios e Redes de Colaboração

A Prof. Carolina Felicíssimo (RNP) detalhou as iniciativas de Ciência Aberta com repositórios de dados de pesquisa nas universidades brasileiras, ressaltando o papel da RNP no apoio à infraestrutura.

A Transformação Digital e o Papel dos Repositórios: A pesquisa científica atual opera em uma velocidade muito alta, com dados sendo gerados continuamente, elevando a dificuldade de manter o rigor científico. Os repositórios de dados de pesquisa são soluções tecnológicas e informacionais que fornecem suporte para o ciclo de vida completo do dado, desde a coleta até a publicação, permitindo a rastreabilidade (versões) e o reuso.

Alinhada à recomendação da UNESCO (que estabelece o conhecimento como um bem humanitário), a RNP tem atuado na criação de infraestruturas de Ciência Aberta, utilizando redes nacionais de pesquisa e educação.

O Dataverse e a Rede Brasileira

O software Dataverse, desenvolvido pela Universidade de Harvard, é a solução de código aberto utilizada para esses repositórios. Exemplificado pelo repositório da Universidade Federal de Goiás (UFG), o Dataverse permite a organização hierárquica por comunidades e sub-comunidades, e a atribuição de identificador persistente (DOI) para os dados, essencial para visibilidade e rastreabilidade. O software também oferece ferramentas como o plugin SketcheDA, que permite fazer perguntas diretas a grandes conjuntos de dados (como o Censo da Educação Básica), eliminando a necessidade de download completo.

No Brasil, a RNP e o IBCT coordenam o Núcleo de Dados de Pesquisa (NDP), um grupo de trabalho inserido na Rede Brasileira de Repositórios Digitais (RBRD), que visa promover a conscientização e implantação de repositórios de dados.

Oportunidades e Desafios Regionais

Os desafios na implementação são significativos e incluem a falta de suporte das áreas de TI, carência de infraestrutura para hospedagem e manutenção (o volume de dados de pesquisa exige armazenamento muito maior do que publicações) e questões culturais, éticas e jurídicas.

A estratégia do NDP é incentivar a experimentação do Dataverse e utilizar o repositório Deposita Dados do IBCT para instituições iniciantes, fortalecendo a cultura de dados abertos. A implantação bem-sucedida, como a da UFG, exige uma "dobradinha" de sucesso entre profissionais de TI e de Ciência da Informação.

A Complexidade da Preservação

A preservação digital é vista como uma questão mais complexa, exigindo um alto nível de maturidade institucional. Enquanto os repositórios atuais garantem armazenamento e acessibilidade, a preservação de longo prazo para volumes massivos de dados ainda é um desafio em evolução, que precisa de planejamento claro nas políticas de uso.

Dados de Proveniência para Experimentos de Inteligência Artificial

O Prof. Daniel Oliveira (Instituto de Computação UFF) apresentou a experiência do seu grupo de pesquisa com o uso do Dataverse para garantir a reprodutibilidade e transparência em experimentos computacionais e de Inteligência Artificial (IA).

A Necessidade de Proveniência

Para experimentos de IA, não basta disponibilizar os dados de entrada e o modelo final; é fundamental ter o histórico ou proveniência de como o dado foi transformado e como o modelo foi treinado. Sem essa informação, é impossível auditar, explicar ou identificar problemas no modelo (por exemplo, um modelo de detecção facial enviesado que só funciona para um grupo étnico).

O dado de proveniência (o caminho de derivação do dado) é tão importante quanto os resultados.

Integração Automatizada com Dataverse

O grupo da UFF, em parceria com a COPPE/UFRJ, utiliza a ferramenta DL Prov para capturar automaticamente o histórico de execução (metadados de proveniência) dos pipelines de aprendizado de máquina. O grande desafio tecnológico foi integrar essa captura de proveniência com o armazenamento e publicação no repositório.

A solução desenvolvida (chamada de D-Prop) é um componente que automatiza o upload dos dados, modelos e dados de proveniência (em formato W3C PROV) para o Dataverse, organizando-os em comunidades e conjuntos de dados. O objetivo é tirar o encargo da publicação manual do pesquisador, que muitas vezes já possui uma rotina atribulada, garantindo que o pacote completo (dados, modelos e histórico) esteja disponível para reuso e auditoria.

Escalabilidade e Planejamento: A principal dificuldade técnica continua sendo a escalabilidade. O volume de dados gerado em computação, especialmente por grandes modelos de linguagem (LLMs) ou projetos como o LSST (que gera 10 TB a cada 3 ou 4 dias), exige soluções de armazenamento massivas, o que representa um desafio enorme para as universidades.

O professor concluiu que a Ciência Aberta deve ser planejada e não tratada apenas como uma consequência ou uma tarefa a ser feita após a pesquisa. Essa abordagem de integração força o pesquisador a definir e planejar o que será capturado e compartilhado desde o início do projeto.

As palestras convergiram na visão de que a soberania da ciência nacional depende da mobilização das universidades, centros de pesquisa e agências estaduais para integrar esforços em prol da Ciência Aberta e de dados bem gerenciados. O trabalho é reconhecidamente complexo, mas essencial para garantir que o conhecimento produzido seja encontrado, compreendido e reutilizado com confiança.