A inteligência artificial chegou prometendo encurtar caminhos: escrever mais rápido, revisar mais cedo, detectar inconsistências, analisar grandes volumes de dados, driblar barreiras linguísticas, etc. Mas a pergunta incômoda — e inevitável — é o que acontece com a confiança quando a eficiência vira objetivo dominante?

À medida que editores e pesquisadores experimentam ferramentas generativas, crescem os sinais de que ganhos de tempo e escala podem vir acompanhados de novas fricções: suspeitas de autoria, vieses contra quem declara uso de IA, decisões editoriais orientadas por detectores que oferecem pouca transparência. O dilema não é teórico; ele se apresenta, com cores diferentes, em textos recentes publicados em 2 canais importantes para a publicação científica: o The Scholarly Kitchen e o blog SciELO em Perspectiva.

O artigo de Tony Alves, profissional com décadas na indústria editorial e colunista do blog The Scholarly Kitchen, sinaliza como o eixo do debate internacional mudou, deslocando-se da pergunta se “a IA ajuda?” para “sob quais condições ela não corrói a confiança?”. Já o texto de Rafael Sampaio, professor permanente do PPG em Ciência Política da UFPR e autor de livros sobre o uso da IA na pesquisa acadêmica, mostra o que acontece quando essa confiança é frágil: declarar uso de IA vira custo reputacional, empurrando o disclosure para as sombras. Postas lado a lado, as duas leituras se complementam e oferecem a reflexão de que é possível colher produtividade sem sacrificar legitimidade, mas isso exige escolhas institucionais deliberadas.

Quando a eficiência vira critério e a confiança fica implícita

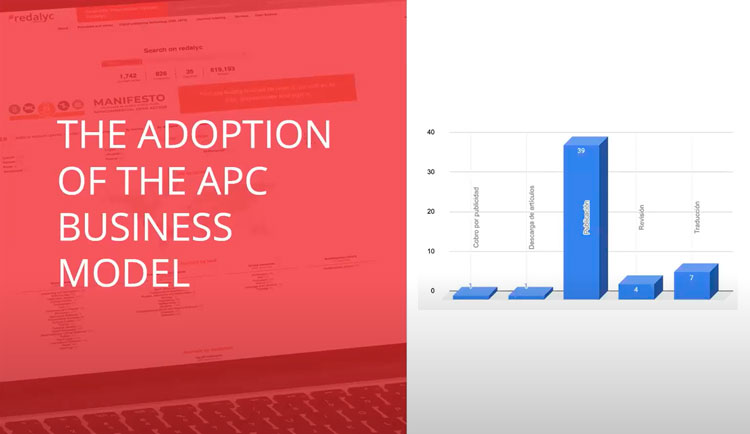

O retrato do debate global, proposto por Alves ao comparar as duas edições mais recentes do Peer Review Congress, descreve uma linha do tempo reveladora. Em poucos anos, a IA passou da periferia (edição de estilo e triagem de imagens, por exemplo) para o centro do fluxo editorial, participando da escrita de rascunhos, da checagem de métodos e até de pareceres-piloto. Essa aceleração cria um risco: medir sucesso apenas por métricas de produtividade — mais submissões processadas e decisões mais rápidas — enquanto a confiança continua não mensurada. O resultado é a tentação de delegar a ferramentas de detecção o papel de guardiãs de integridade, apesar de sua natureza probabilística e de seus vieses. A eficiência, aqui, não é inimiga da confiança; ela apenas a eclipsa quando os instrumentos de controle são usados como fins, e não como meios.

O custo moral da pressa: transparência que penaliza

É nesse ponto que Sampaio introduz o paradoxo com um recorte essencialmente latino-americano: quando declarar o uso de IA reduz as chances de aceitação — ainda que o uso tenha sido restrito à revisão linguística — a honestidade vira um luxo. A pressa por produtividade, combinada com sinalizações ambíguas de políticas editoriais, produz um sistema onde a aparência de “pureza textual” vale mais do que a substância metodológica. O ganho de eficiência se paga com moeda de confiança: autores passam a esconder práticas legítimas para evitar a leitura enviesada de revisores ou editores, e a comunidade perde visibilidade sobre como a IA de fato circula na produção de conhecimento.

Duas lentes, um mesmo ponto cego

As duas fontes partem de contextos distintos, mas convergem no diagnóstico do ponto cego: não basta regular o “quê” da IA, é preciso governar o “como”. A eficiência é compatível com a confiança quando o processo deixa menos espaço para arbitrariedades: políticas que diferenciam claramente assistência linguística de geração de conteúdo; registros objetivos do uso (quem, quando, para quê); e decisões editoriais que não tomam o disclosure como indicador de qualidade.

Transparência em via de mão-dupla

Entre o ímpeto de decidir rápido e a necessidade de julgar com justiça, a transparência precisa operar nos dois sentidos: editores devem revelar como processam declarações de uso de IA nas políticas do periódico e autores devem explicitar como a incorporaram ao trabalho. Essa reciprocidade só funciona quando há um vocabulário comum para qualificar o uso.

A fronteira operacional entre assistência linguística e geração de conteúdo é mais do que semântica; ela separa ganhos de eficiência que reduzem assimetrias daqueles que podem distorcer o registro científico. Ao classificar a edição de clareza, a tradução e a reorganização textual como formas de assistência, ambos os textos abrem espaço para que a IA funcione como niveladora — especialmente para autores que escrevem em inglês como segunda língua. Já a produção de parágrafos, a síntese de resultados e a criação de figuras ou dados entram na esfera da geração, onde a responsabilidade e o disclosure precisam ser robustos e fundamentados. Essa tipologia não limita a inovação; ela a condiciona à prestação de contas.

A tentação de “escanear” automaticamente manuscritos para decidir o que é aceitável é grande, mas tem custo e não apenas financeiro. Detectores de IA são, no melhor dos casos, sinais insuficientes. Usados como gatilho de rejeição, amplificam injustiças, rotulam assistência legítima como fraude e incentivam o silêncio. Usados como entrada para um diálogo editorial — pedido de esclarecimento, solicitação de versão com disclosure, checagem de coerência entre texto e materiais subjacentes — eles podem contribuir para a confiança sem sequestrar o juízo. A eficiência aqui não está em automatizar a decisão, mas em automatizar o trilho do devido processo.

Toda política é também uma política de incentivos. Se declarar uso de IA tiver alto custo, poucos declararão. Se a triagem inicial é cega ao disclosure e os formulários orientam o autor a distinguir categorias de uso com exemplos, mais autores agirão com transparência. Se os relatórios semestrais do periódico publicam taxas agregadas de disclosure e as ações tomadas, a comunidade entende que transparência não é armadilha, é compromisso. É a passagem de um modelo punitivo — que aposta em detectores como polícia — para um modelo preventivo — que aposta em desenho de processo e educação contínua.

Propostas para que a eficiência trabalhe a favor da confiança

- Explicitar categorias de uso com regras proporcionais: edição/tradução como assistência com disclosure simples; síntese, escrita e geração de elementos como conteúdo com disclosure detalhado e assinatura de responsabilidade explícita.

- Adotar triagem cega ao disclosure nas etapas iniciais, liberando a informação apenas quando necessário para a decisão final.

- Substituir rejeições sumárias por respostas proporcionais (pedido de esclarecimento, versão revisada, complementação de materiais), reservando sanções para casos de engano deliberado.

- Treinar a equipe editorial e pareceristas para avaliar mérito científico independentemente do verniz estilístico, reduzindo o viés contra autores que dependem de assistência linguística.

- Publicar relatórios de transparência com indicadores que permitam à comunidade acompanhar se os incentivos estão alinhados.

Conclusão: o pacto entre o atalho e a prova

As reflexões propostas por Alves e Sampaio nos lembram é que a eficiência é tentadora e a confiança é trabalhosa — e que o futuro da comunicação científica depende de um pacto entre as duas. A IA pode acelerar a escrita, a revisão e a checagem, mas só cumpre sua promessa quando opera sob políticas que tratam a transparência como bem público e o mérito científico como bússola. O caminho não está em escolher um lado, e sim em alinhar processos, métricas e incentivos para que a pressa nunca suplante a prova. Quando o atalho é desenhado com responsabilidade, ele não encurta a confiança; ele encurta o caminho até ela.

Referências

- Alves, Tony. “Guest Post – How the AI Debate Has Changed in Just a Few Short Years”. The Scholarly Kitchen, 24 de setembro de 2025, https://scholarlykitchen.sspnet.org/2025/09/24/guest-post-how-the-ai-debate-has-changed-in-just-a-few-short-years/.

- Sampaio, Rafael Cardoso. O Paradoxo Da Transparência No Uso de IA Generativa Na Pesquisa Acadêmica | SciELO Em Perspectiva. https://blog.scielo.org/blog/2025/10/10/o-paradoxo-da-transparencia-no-uso-de-ia-generativa-na-pesquisa-academica/. Acesso em 16 de outubro de 2025.

Texto produzido com auxílio de Inteligência Artificial e revisado pelo autor Nossa newsletter agora está no Substack e você pode se inscrever gratuitamente para recebê-la diretamente em seu email, ler no app e acessar todo o conteúdo do ecossistema Peletron!Assine nossa newsletter